制胜中国新篇章

最新洞见

打造21世纪领导力工厂: CEO才是“首席教练”

在动荡与变革交织的时代,CEO及其团队必须把目光牢牢聚焦在一件事上:系统性培养下一代领导者,使其具备独特能力与心智,能够在高压与不确定中扛起重任、持续成长。这是一项集体工程,但唯有CEO与高管团队高度协同、亲自推动,理念才能真正落地,成长才会真正发生。

中信戴卡摩洛哥总裁巴德·拉穆迪:海外更需要中国的解决方案,而不只是中国的产品

本次访谈中,中信戴卡摩洛哥工厂总裁巴德·拉穆迪(Badr Lahmoudi)与麦肯锡全球董事合伙人侯文皓围绕着非洲首家“灯塔工厂”的建设与转型,探讨了其独特的成功要素,并分享了克服跨国运营挑战(人才、文化、供应链)的可复制经验,以及对非洲的工业企业和中国企业“出海”的关键启示。

问错问题,再完美的答案都是灾难

问题一旦被错误界定,再努力寻找答案,也只会南辕北辙。哪怕出发点再正确,管理者也会常常在无意中陷入认知与组织层面的偏见,进而影响决策质量。本文将系统梳理这些隐秘却顽固的心理机制,并提供切实可行的应对之策。

对话200位顶尖CEO:揭示领导者的认知盲区与实战解法

从上任初期的过度自信,到任期后段战略清晰度的流失,盲区几乎贯穿CEO履职的全过程。本文系统梳理了CEO在不同阶段最易忽视的关键风险点。如同四季轮转,CEO的履职生涯也可分为四个阶段。每一阶段,都伴随着独特的机遇与挑战,正如春夏秋冬,各有其气候与节律。

AI智能体组织: 5个人管理100个智能体员工

企业正迈入一种全新的组织形态:人类不再单打独斗,而是与虚拟或实体的AI智能体并肩协作,共创价值。本文基于早期实践者的真实经验,总结这一新范式的关键特征,并探讨企业可即刻行动的路径。

独家访谈|麦肯锡全球资深董事合伙人叶海:“韧性增长”取代“高速增长”,未来十年企业要做对三件事

当下的中国市场,正在经历一次不那么喧闹、却足够深刻的结构性变化:增速放缓、价格竞争加剧、消费者更谨慎、成本结构重塑。越来越多企业意识到——曾经自动提供增长的外部红利正在退潮,新的成长方式必须建立在组织重塑、能力提升与领导心态迭代之上。麦肯锡全球资深董事合伙人叶海在近来一次访谈中,用一个词概括这个时代:韧性增长时代。

中国灯塔工厂数量已突破百家大关

今日,全球灯塔网络再添新军——23家智造标杆企业获评加入。自2018年启动以来,全球灯塔网络见证了工业转型七年来的持续突破。该网络已扩展至全球30多个国家、40多个行业,成员总数超过220家,并从传统的制造场景延伸至端到端供应链。这不仅展现了全球灯塔网络持续增长的势头,更折射出全球工业领域日益高涨的转型雄心。

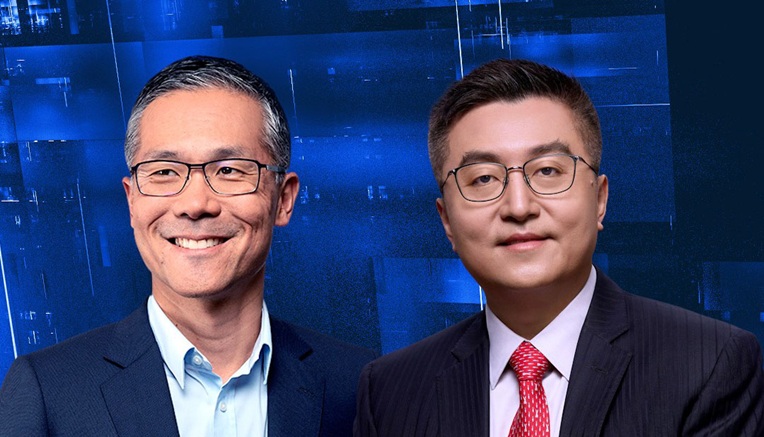

从电动车到机器人:小鹏是如何做到的?——专访小鹏汽车副董事长兼联席总裁顾宏地

麦肯锡中国区主席倪以理访谈了小鹏汽车副董事长、联席总裁顾宏地。对话中,顾宏地系统梳理了中国电动车产业的演进逻辑、全球化布局、智能驾驶与AI战略,并对小鹏向机器人与具身智能延展的愿景展开深入探讨。

新官上任:新任CEO的相关方管理手册(上篇)

新任或候任CEO往往会低估内外部沟通的复杂性与强度;而心态是否到位、沟通是否高效、行动是否得当,往往是决定成败的分水岭。也正因如此,我们撰写了这篇文章,希望为你提供一份主动而持续地管理相关方关系的“实战手册”。

CEO访谈

中信戴卡摩洛哥总裁巴德·拉穆迪:海外更需要中国的解决方案,而不只是中国的产品

本次访谈中,中信戴卡摩洛哥工厂总裁巴德·拉穆迪(Badr Lahmoudi)与麦肯锡全球董事合伙人侯文皓围绕着非洲首家“灯塔工厂”的建设与转型,探讨了其独特的成功要素,并分享了克服跨国运营挑战(人才、文化、供应链)的可复制经验,以及对非洲的工业企业和中国企业“出海”的关键启示。

从电动车到机器人:小鹏是如何做到的?——专访小鹏汽车副董事长兼联席总裁顾宏地

麦肯锡中国区主席倪以理访谈了小鹏汽车副董事长、联席总裁顾宏地。对话中,顾宏地系统梳理了中国电动车产业的演进逻辑、全球化布局、智能驾驶与AI战略,并对小鹏向机器人与具身智能延展的愿景展开深入探讨。

安捷伦科技全球副总裁曹伟胜:推进数字化运营是最值得做的无悔之举

本次访谈中,安捷伦科技全球仪器制造副总裁曹伟胜与麦肯锡全球董事合伙人侯文皓共同探讨了安捷伦智能制造转型之旅。曹伟胜分享了他的心得体会:强大的领导力、匹配的人才队伍与创新的技术,助力安捷伦将愿景蓝图转化为行动,最终实现产品交付与研发效率的双重提速。